2025年年度工作总结

智能体系统组

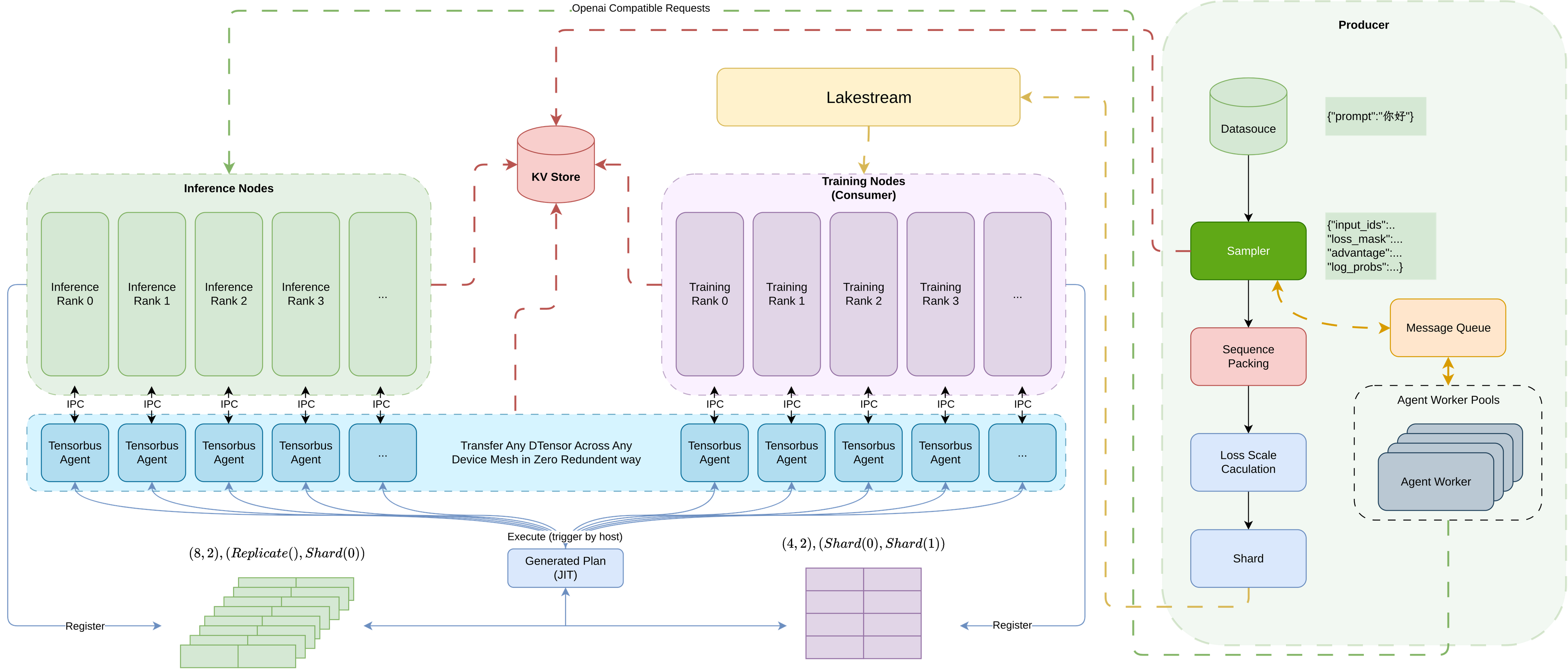

L0: 端到端RLVR 训练流水线与 Notebook Agent 框架

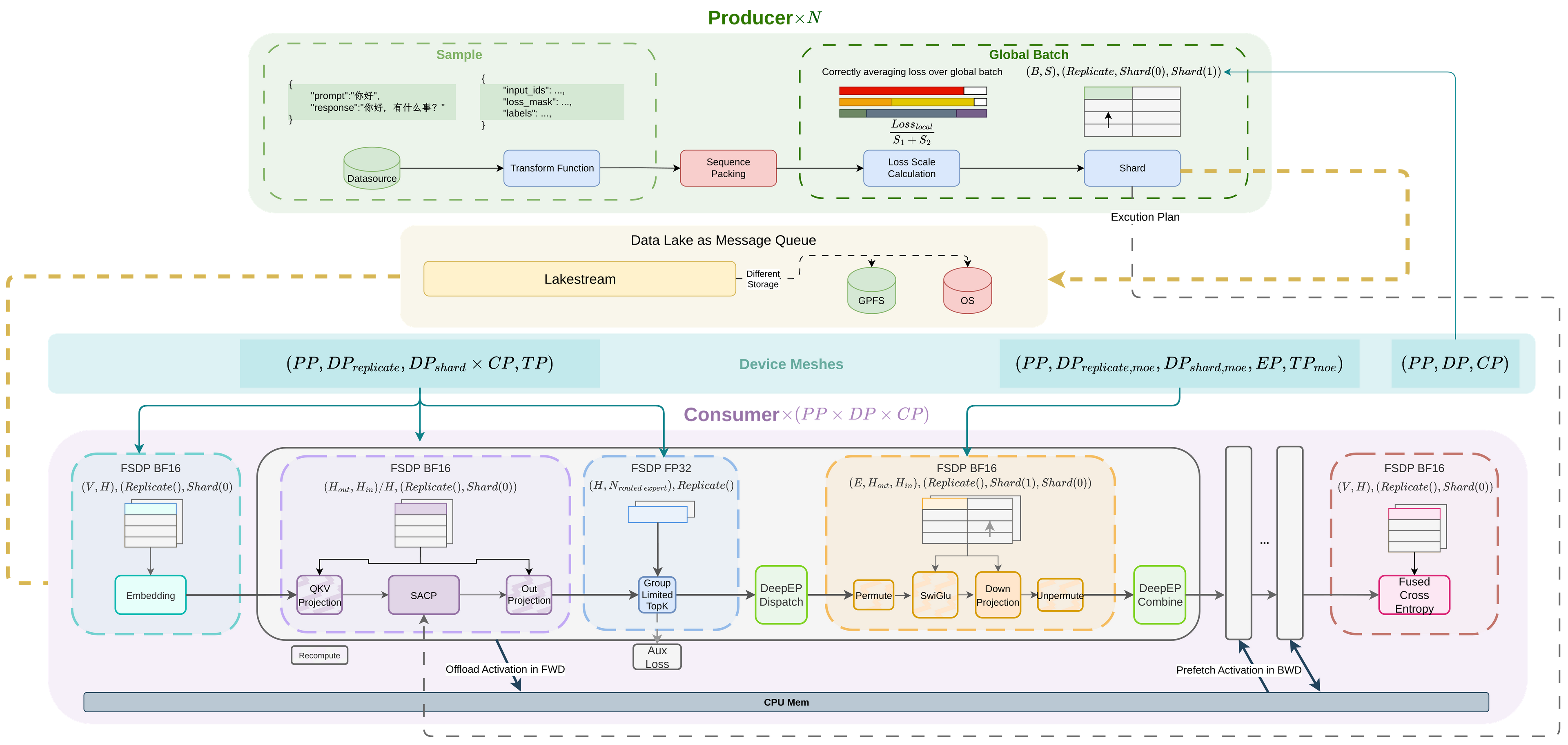

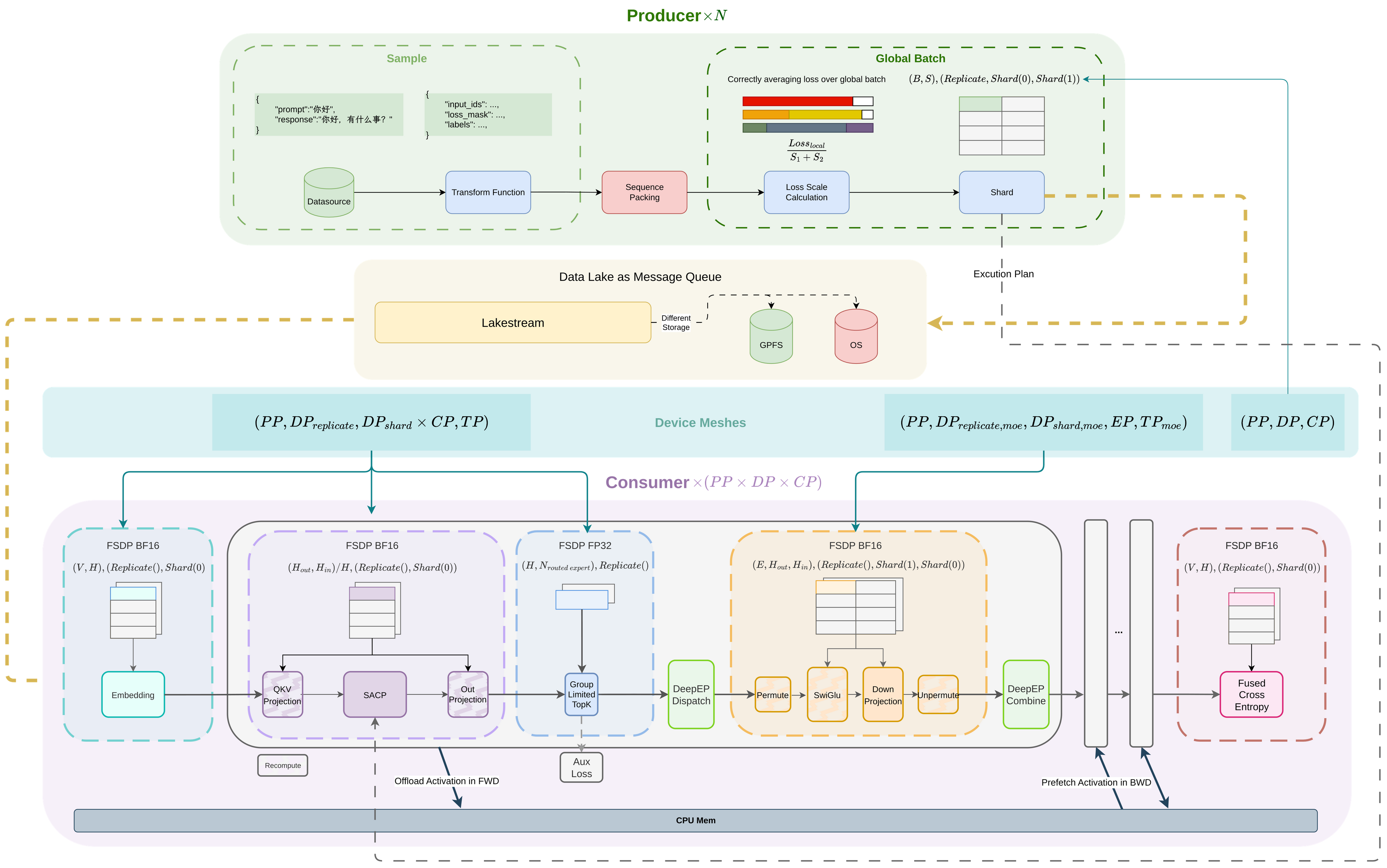

自研万亿级模型分布式训练基础设施

自研万亿级模型分布式训练基础设施

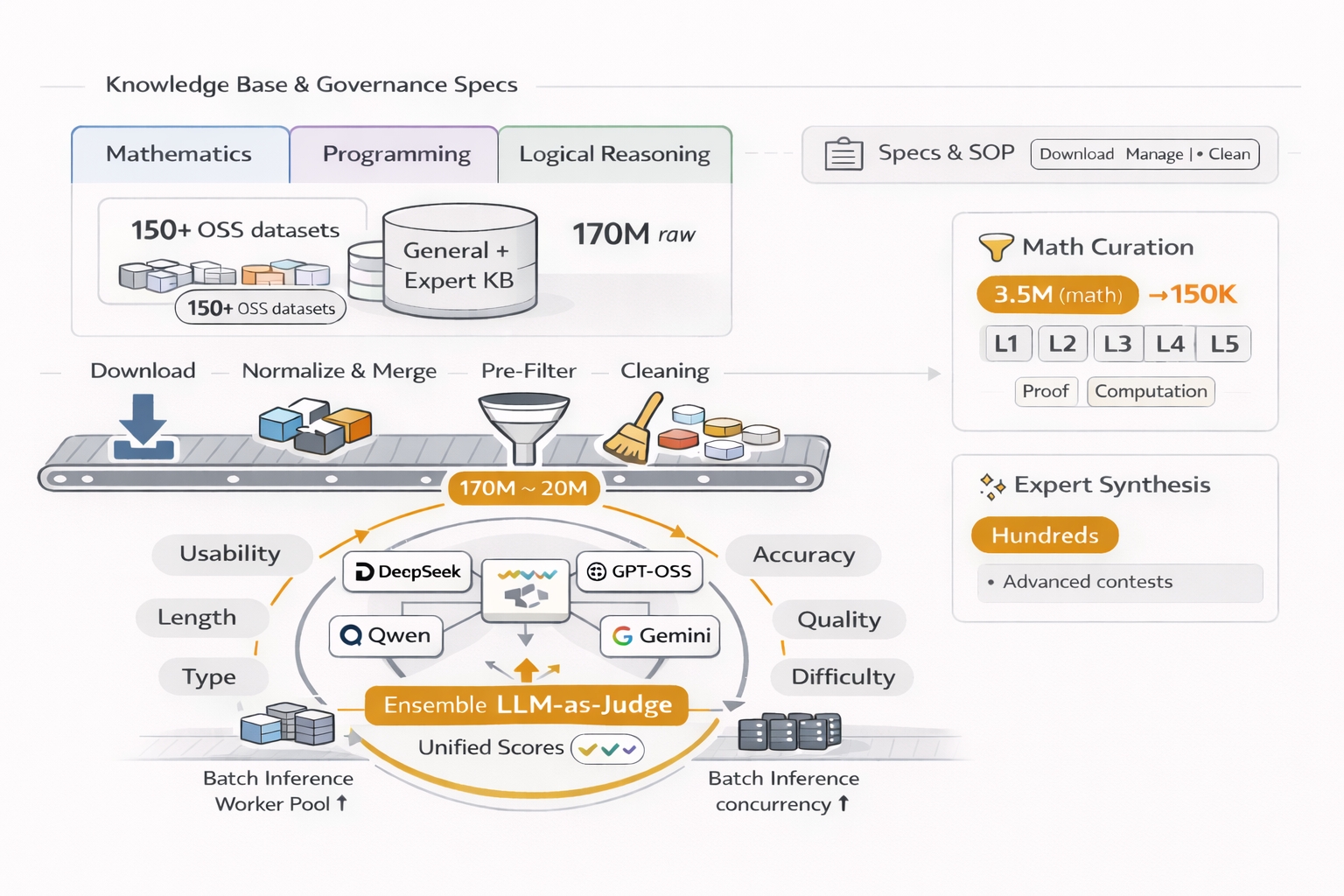

建设大规模后训练数据流框架

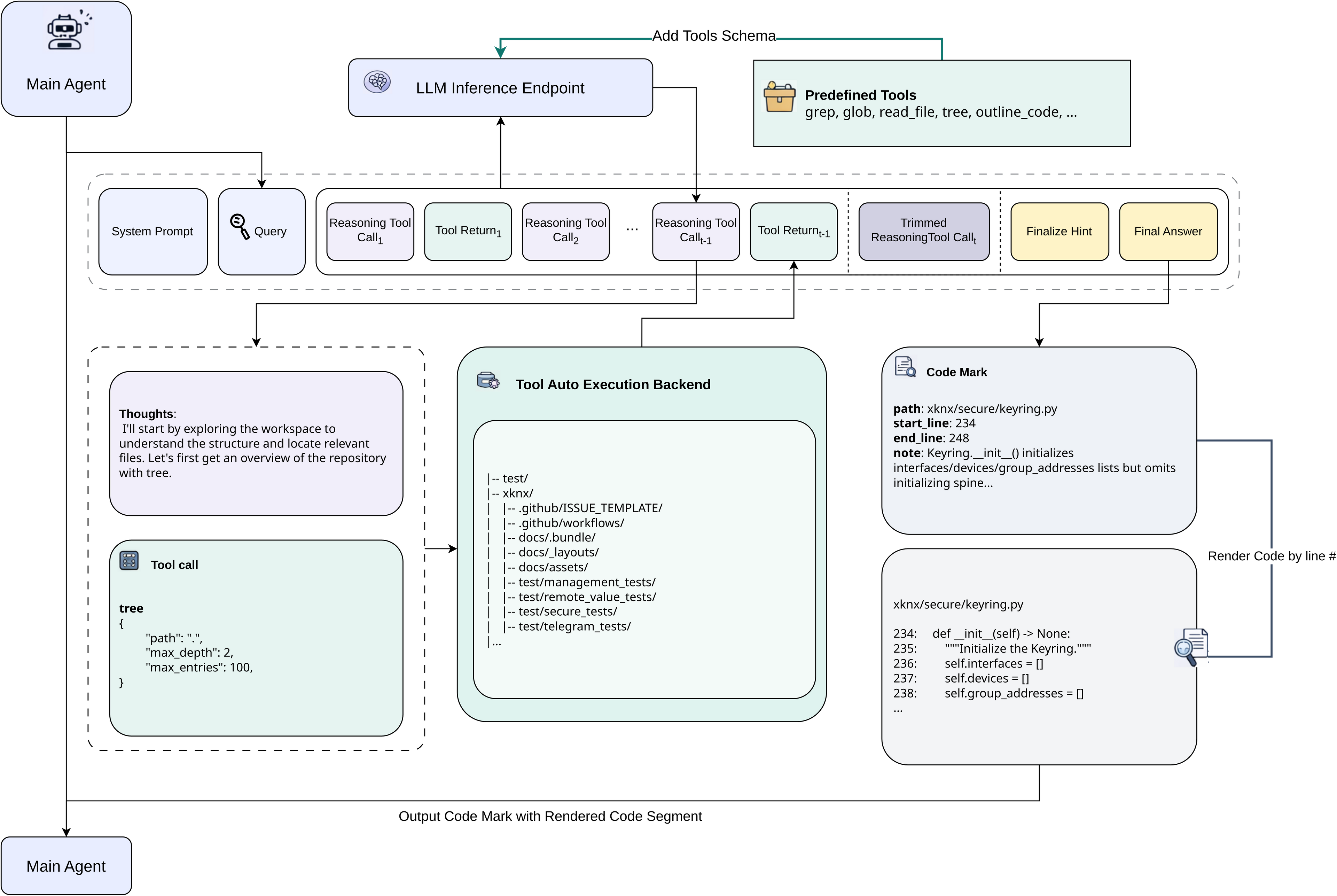

构建智能体数据合成与训练评测闭环体系

Agentic Grep: 通往智能上下文召回

未来工作

- 系统性解决目前智能体后训练推理长尾问题:

- 长序列并行推理

- 缓存复用

- 智能体记忆优化

- 提高智能体强化学习上限

- 提高大模型输出的多样性

- 闭环代码执行沙盒->可观测性->日志收集, 提升后训练可扩展性

- 从代码导航到自主编程智能体

- 自主提出编程方向

- 在线持续学习